Hur kan vi lita på AI?

Inom samhällsbyggnad och i samhället i allmänhet är just nu den vanligaste lösningen på alla möjliga problem någon form av Artificiell Intelligens, AI. Så även i undermarksbyggandet och inom geotekniken. Alla AI-verktygen är svarta lådor. Och skulle vi få möjlighet att titta in i dessa lådor skulle väldigt få av oss ha förmågan att förstå de algoritmer som gör beräkningarna och spottar ut de resultat som vi använder. Vad är det som gör att vi litar på resultaten? Och geotekniken har några extra utmaningar jämfört med många andra discipliner. Det är svårt att få tillgång till de stora dataset som krävs. Och hur ofta har vi något verkligt facit att validera mot?

AI är svårt

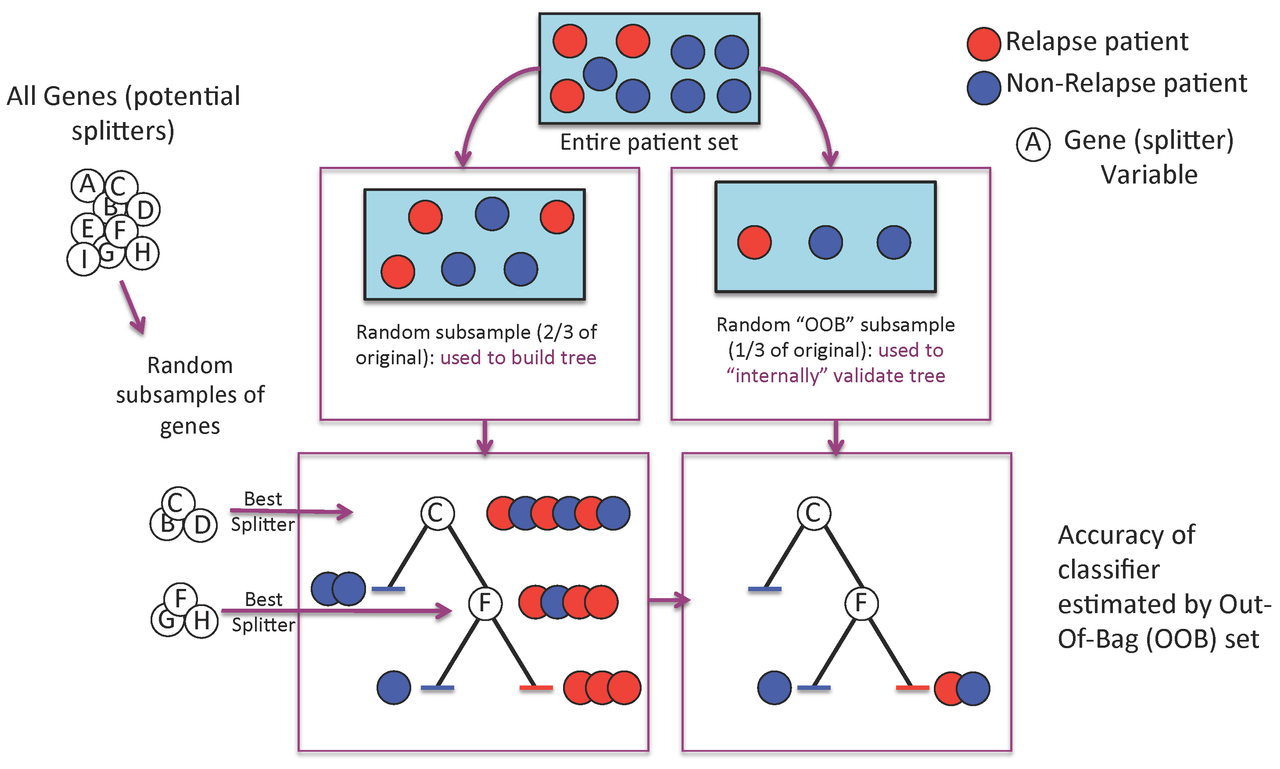

Dessutom används, liksom i detta inlägg, ofta AI som samlingsnamn för Neurala nätverk, Machine learning, Genetic algorithms mm. Principen för utveckling av en AI-algoritm är, grovt generaliserat, att man utnyttjar hälften av sin stora datamängd för att träna den på att beräkna rätt svar. Ett georelaterat exempel är tex att utifrån olika borrdata beräkna en bergmodell mellan borrhålen i 3D.

Att träna AI-algoritmen betyder att den själv anpassar sig (genetic algorithms) så att den efter ett stort antal iterationer har hittat inställningar på olika ingående parametrar så att svaret, den framräknade bergmodellen, passar tillräckligt bra mot den datamängd som den tränas på. Därefter utnyttjar man den andra halvan av datamängden för att validera sin algoritm. Man använder alltså nya data som inte har använts för träningen av algoritmen för att data ska vara oberoende.

Tittar man in i dessa algoritmer har de benämningar som Random forest, Bagging regressor, Gradient boosting regressor osv. Matematiken och programmeringen för att hantera dessa algoritmer och få dem att räkna rätt är inte enkel. Vilken förmåga har vi i branschen att kvalitetssäkra de AI-verktyg och dess resultat? Får vi ens möjligheten att titta in i de svarta lådorna?

AI kräver stora datamängder

Hur ser det ut med tillgången på data inom undermarksdisciplinerna – geoteknik, berg, grundvatten, förorenad mark? Artiklar och diskussioner om AI åtföljs ofta av begreppet Big Data. Det behövs tillgång till stora datamängder för att det ska bli bra kvalitet på AI-algoritmer. Beroende på aktuell tillämpning är behovet olika.

Framtagning av en bergmodell baserad på undersökningsdata är en vanlig tillämpning. Av vad som hittills har publicerats i branschen har jag inte sett något exempel där antalet borrpunkter är tillräckligt stort för att få fram en AI-algoritm som gör en bättre bedömning av bergmodellen är vad som kan göras med traditionella metoder (vilka inte alltid är så träffsäkra). Och även om det skulle ha funnits en nationell databas med alla geotekniskt relaterade data tillgängliga krävs det lokala anpassningar av varje AI-algoritm eftersom geologin kan skilja stort mellan olika lokaler.

En nationell databas hade givetvis varit en bra start och oerhört värdefull av en hel massa andra skäl.

AI kräver ett facit

Den kanske viktigaste delen i AI-arbetet är att ha tillgång till ett bra valideringsunderlag. Alltså att ha tillgång till facit. Om jag fortsätter med tillämpningen beräkning av bergmodell enligt ovan behövs det alltså en framschaktad och inmätt bergyta som AI-algoritmens framräknade bergmodell kan jämföras med. Det är då man får ett mått på hur träffsäker AI-algoritmen är. På olika konferenser och branschdagar publiceras det nu ibland bergmodeller där man anser att bergmodellen är validerad eftersom AI-algoritmen har bra passning mot den tolkade bergnivån i de enstaka borrpunkterna, tex från Jb. Det känns inte rätt.

Just tillgång till ett facit är en särskild utmaning för många AI-tillämpningar inom geodisciplinerna.

Sammanfattningsvis

Självklart ska vi inom geodisciplinerna ta del av alla de fantastiska möjligheter som AI-utvecklingen möjliggör. Men vi måste vara medvetna om utmaningarna och se till att vi har den kompetens som krävs. Vi ska vara sunt kritiska till hur vi använder AI-verktygen och kräva mycket bättre pedagogik och transparens av de som utvecklar dem.

Vi själva måste bli bättre på att organisera och dela på data. Genom at tdela på alla data utvecklar vi både branschen och oss själva. Det gynnar alla. Kraften och pengarna ligger i att dela på data, open data. Det är bara en (ganska kort) tidsfråga innan alla data kommer att vara öppet tillgängliga för alla. Ju tidigare vi kan utveckla verktyg, tex AI-verktyg, som utnyttjar de stora dataset som vi dagligen samlar in, ca 150 st borrvagnar i Sverige, desto bättre är det.

Till sist ett lästips: Genetic algorithms, David E Goldberg, 1989. Originalet, som jag läste 1994. Förstod inte mycket då, lite mer nu. Och det är nu det händer.